Intelligence artificielle: Comment les programmes d'IA influencent les prévisions météorologiques

Sebastian Wache

· 12.09.2024

- La météorologie est un terrain d'essai idéal pour l'IA

- Supériorité dans la prévision des conditions météorologiques extrêmes

- Les modèles de prévision à long terme deviennent plus stables et plus fiables.

- Voir ce qui doit se passer toutes les 15 minutes grâce à l'IA

- Des météorologues seront nécessaires à l'évaluation à l'avenir également

- Et qu'est-ce que l'IA nous apporte à nous, les navigateurs ?

- Comparaison des prédictions conventionnelles et des prédictions générées par l'IA

- Quelle est la fiabilité des anciens et des nouveaux modèles de prévision météorologique ?

L'intelligence artificielle (IA), ou Artificial Intelligence en anglais, est actuellement sur toutes les lèvres, qu'il s'agisse d'images, de vidéos, de musique ou d'autres choses. Dans tous les cas, on essaie d'entraîner l'ordinateur pour obtenir des résultats meilleurs que ceux obtenus jusqu'à présent, et qui devraient aussi nous faciliter la vie en général ou du moins rendre les processus de travail plus efficaces.

L'exemple le plus connu est Chat GPT. Aujourd'hui dans sa quatrième version, cet outil logiciel ne doit pas seulement cracher des textes, mais aussi pouvoir mener de véritables conversations. L'IA est également utilisée en météorologie. Mes collègues du département informatique l'utilisent déjà volontiers et régulièrement pour examiner, générer et aussi améliorer des codes de programmation. Et cela fonctionne à merveille !

Les ordinateurs sont donc formés à l'aide de connaissances existantes. S'il existe une demande spécifique qu'elle connaît peut-être déjà, la machine évalue quelle est la réponse la plus probable. Souvent, les résultats correspondent déjà assez bien ou s'améliorent de requête en requête.

Également intéressant :

Lorsqu'il s'agit d'estimer des probabilités, nous nous retrouvons presque inévitablement dans les prévisions météorologiques. Depuis longtemps, différents modèles et de nombreux calculs individuels permettent d'estimer le temps qu'il fera dans les jours à venir. Un système très chaotique, capable de fournir des prévisions exactes parfois sur dix jours, parfois sur moins de 24 heures.

La météorologie est un terrain d'essai idéal pour l'IA

Les modèles météorologiques se répètent en principe et suivent principalement les règles de la thermodynamique atmosphérique. La structure de base est donc établie. C'est ce qu'ont pensé entre autres Google et le Centre européen pour les prévisions météorologiques à moyen terme (CEPMMT).

Google dispose de l'infrastructure nécessaire aux calculs d'IA sous la forme d'ordinateurs centraux, et le CEPMMT dispose d'une grande quantité de données météorologiques. La combinaison de ces données a donné naissance au modèle météorologique GraphCast. Ce modèle encore expérimental a été alimenté par des données dites de réanalyse. On a donc mélangé des valeurs de mesure avec des données de modèle afin d'obtenir les grandes situations météorologiques mondiales des dernières décennies. En effet, jusqu'à il y a une trentaine d'années, le réseau de mesure n'était pas aussi dense qu'aujourd'hui.

De cette manière, la situation météorologique a été recalculée à l'envers. Le modèle GraphCast a ensuite été alimenté par la météo mondiale des années 1979 à 2017. Il a appris comment les modèles météorologiques se comportent et quel temps en résulte dans les différents endroits du monde pour les jours suivants.

Pour lancer le calcul d'une prévision météorologique, il suffit en effet de connaître les modèles de répartition globale de la pression des six heures précédentes ainsi que la situation actuelle. Combiné avec ce que vous avez appris, cela suffit pour obtenir une prévision pour les heures suivantes.

Mais un communiqué de presse de Google a ensuite électrisé les spécialistes. D'une part, parce que le modèle généré par l'IA présente un taux de réussite de plus de 90 pour cent. Mais nous, les météorologues, avons été encore plus impressionnés par le fait que moins d'une minute de calcul est nécessaire pour établir une prévision aussi fiable pour les dix prochains jours ! À titre de comparaison, les modèles météorologiques opérationnels utilisés jusqu'à présent ont besoin d'environ quatre à six heures pour obtenir un résultat.

Supériorité dans la prévision des conditions météorologiques extrêmes

Comment cela fonctionne-t-il ? Eh bien, dans le modèle du CEPMMT, 52 sessions individuelles sont lancées simultanément, chacune avec de petits changements dans les conditions initiales. Après jusqu'à six heures, une estimation est faite. Les lignes les plus proches indiquent également la trajectoire la plus probable des systèmes météorologiques des jours à venir. Ce que l'on peut voir par exemple sur Windy comme modèle ECMWF n'est donc rien d'autre que le résultat le plus probable de 52 calculs de modèles individuels.

Pour les prévisions locales, il est possible d'afficher les 52 prévisions individuelles. Il peut donc arriver qu'une course donne une température de 30 degrés pour Hambourg, par exemple, alors qu'une autre ne prévoit que 15 degrés pour le même jour. Toutes les autres courses se situent entre les deux, ce qui signifie qu'il y a de fortes chances pour que la température avoisine les 20 degrés.

Il est même possible aujourd'hui de consulter les résultats des différentes analyses non seulement pour un site donné, mais aussi pour de grandes régions. Ainsi, avec un seul modèle météo, on disposerait de 52 cartes météo différentes, parmi lesquelles il suffirait de choisir la plus probable.

Il est vrai que tout cela semble un peu compliqué, et c'est pour cela que le temps de calcul est long. GraphCast a donc été testé par rapport à ce modèle ECMWF - et donc par rapport au modèle le plus fiable à ce jour. En ce qui concerne la précision des paramètres de vent, de température et de pression atmosphérique, il a été immédiatement supérieur. Mais apparemment aussi pour la prévision des situations météorologiques extrêmes, bien qu'il n'ait pas encore été entraîné à cet effet !

Toutefois, deux modèles météorologiques relativement grossiers ont été comparés. GraphCast a été utilisé avec une grille de 28 kilomètres par 28 kilomètres et le modèle ECMWF a été utilisé avec exactement la même grille. Cela signifie qu'il n'y a des points qui produisent des résultats que tous les 28 kilomètres de longueur géographique et également tous les 28 kilomètres de largeur géographique. Cela permet de prévoir les trajectoires et l'évolution des anticyclones et des dépressions, mais pas les phénomènes locaux comme le vent marin.

Les modèles de prévision à long terme deviennent plus stables et plus fiables.

De nos jours, il est toutefois possible de travailler à une échelle beaucoup plus petite. Le modèle ICOND2 du service météorologique allemand a une résolution de 2,1 kilomètres. C'est encore une grande avance sur l'IA. Si GraphCast ou d'autres modèles d'IA atteignent cette résolution ou deviennent encore plus petits, des événements plus régionaux comme les orages et peut-être les tornades seront certainement plus faciles à prévoir à l'avenir.

Comme si cela ne suffisait pas, Google a co-développé des extensions en plus de GraphCast, comme NeuralGCM. Il s'agit d'un modèle qui combine l'IA et la méthode traditionnelle de prévision météorologique basée sur la physique : Des phénomènes atmosphériques à grande échelle sont simulés et, en même temps, des caractéristiques plus petites comme les nuages et les précipitations sont estimées avec précision à l'aide de réseaux neuronaux. Cela devrait permettre aux modèles de fonctionner de manière plus stable et plus fiable pour les prévisions à long terme.

De même, le géant du logiciel a associé un autre outil à l'IA : Scalable Ensemble Envelope Diffusion Sampler (SEEDS) est le nom de la méthode qui, comme nous l'avons vu plus haut, permet également de calculer de nombreux cycles de prévision différents afin d'estimer quel scénario est le plus susceptible de se produire. Cette méthode permet avant tout de détecter plus tôt les événements météorologiques extrêmes.

En principe, il ne s'agit pas d'une nouvelle méthode, mais grâce à l'IA, ces nombreuses variantes de prédiction sont générées en une fraction du temps de calcul actuel. Ceux qui souhaitent se faire une idée de la précision déjà atteinte par le modèle GraphCast peuvent le faire sans problème. Les cartes météo quotidiennes du projet sont disponibles sur le site du CEPMMT et peuvent être comparées avec celles du modèle opérationnel.

Voir ce qui doit se passer toutes les 15 minutes grâce à l'IA

Si les applications d'IA continuent à faire leur entrée sur la scène météorologique et remplacent les modèles numériques actuels - et elles le feront ! -, les conséquences seraient énormes. La capacité de calcul économisée serait notamment disponible pour d'autres applications. Le service météorologique français a par exemple lancé sur le marché un nouveau modèle, Arome PI, qui, outre la situation météorologique actuelle, calcule non seulement heure par heure, mais aussi 15 minutes à l'avance. Il devrait donc être de plus en plus précis et fin pour voir où se déplacent par exemple les averses et si et surtout où de nouvelles se forment.

Jusqu'à présent, l'apparition de cellules d'averses et donc, le cas échéant, de fortes pluies avec inondations, ressemble à une loterie : je compare toujours la prévision de l'endroit où se produira la prochaine averse à de l'eau bouillante dans une casserole. Là aussi, personne ne peut dire où les prochaines bulles vont se former.

On peut donc d'ores et déjà cliquer sur les cartes météo et voir toutes les 15 minutes ce qui devrait se passer - en espérant que cela nous rapprochera encore plus de la réalité. Ce sera un outil extrêmement important, notamment pour les alertes météo.

En Chine aussi, on ne reste pas inactif en matière d'IA et de météo. L'entreprise Huawei Cloud tente d'entraîner son propre modèle appelé Pangu- Weather pour des prévisions à sept jours. À l'université de Pékin, on mise en revanche sur des prévisions de précipitations à petite échelle pour seulement trois heures à l'avance à l'aide du modèle d'IA FourCastNet. Ici aussi, les modèles bénéficient des statistiques des dernières années.

Mais cela a aussi ses inconvénients. Notamment lors de situations météorologiques extrêmes, comme nous en voyons de plus en plus souvent dans le monde. De tels événements ne font pas encore partie des statistiques. De même, les ouragans et les typhons de catégorie 3 à 5, appelés ouragans majeurs ou typhons monstres, sont encore trop rarement représentés dans les données pour pouvoir les prévoir de manière fiable. A cela s'ajoute le fait que les équations physiques utilisées par les modèles utilisés jusqu'à présent sont également interdépendantes. Certains processus comme les nuages, le rayonnement et les turbulences sont donc interdépendants et difficiles à modéliser. Il n'est pas facile d'en tenir compte, surtout avec une résolution de modèle de 28 kilomètres sur 28 également.

Des météorologues seront nécessaires à l'évaluation à l'avenir également

Les approches sont donc très différentes. Pangu-Weather n'a utilisé que des données d'observation comme base. FourCastNet, en revanche, qui travaille à une échelle beaucoup plus petite, utilise non seulement l'IA mais aussi les équations physiques et combine les deux. Pangu-Weather est censé calculer 10.000 fois plus vite que les modèles numériques comparables. Il convient donc pour les prévisions à moyen terme, mais ne donne aucune information sur les précipitations. C'est là qu'interviendrait l'autre modèle qui, plus on se rapproche de l'événement météorologique, permet de faire des prévisions plus précises sur la quantité de pluie.

Le fait que nous parlions déjà ici de deux modèles utilisés dans des cas d'application différents montre bien qu'à l'avenir, il ne sera pas possible de se passer du météorologue pour évaluer correctement la situation. L'IA n'est pas si nouvelle en soi, et les navigateurs l'utilisent déjà dans une certaine mesure depuis quelques années. En particulier lorsqu'il s'agit de routage en combinaison avec des prévisions météorologiques.

Pour cela, on travaille avec des outils logiciels comme "Expedition" ou "Adrena" sur la base des diagrammes polaires de son propre bateau. En fin de compte, les programmes proposent probablement la meilleure ou la plus rapide route en tenant compte du vent et des conditions météorologiques.

Ils font avancer le bateau virtuel heure par heure et regardent quel vent souffle à ce moment-là à l'endroit qu'ils ont atteint. Le diagramme polaire montre dans quelle direction et quelle force du vent le bateau navigue le plus rapidement. Ainsi, des isochrones sont générés pas à pas, avec une proposition de route correspondante.

Les navigateurs professionnels ne font rien d'autre plusieurs fois par jour, lorsque de nouvelles données météorologiques arrivent. Les données sur les courants peuvent également être prises en compte. Le logiciel estime ainsi le meilleur cap possible. Mais ces calculs prennent du temps. Surtout si l'on intègre de nombreuses données sur son bateau.

Le tout est également utilisé depuis longtemps dans la navigation professionnelle. L'IA doit indiquer le plus rapidement possible la route optimale et la plus sûre pour les cargos ou les pétroliers, sans avoir recours à de nombreux routeurs météorologiques humains. Le vent, les vagues et les courants permettent notamment d'économiser du carburant et donc des coûts. En même temps, on évite d'être pris dans une tempête et de perdre, le cas échéant, de précieuses cargaisons de conteneurs.

Grâce notamment à l'Internet Starlink à bord, ces calculs ne sont plus effectués sur l'ordinateur de bord, mais sur des serveurs externes. Les données météorologiques actuelles et historiques y sont déjà stockées, ce qui permet d'accélérer les calculs individuels pour un navire donné.

C'est donc déjà l'avenir qui se dessine. Mais nous ne pouvons pas encore nous passer totalement de l'homme et de ses connaissances. Malgré toutes les possibilités techniques déjà existantes, mes collègues et moi restons l'interlocuteur numéro un des capitaines lorsqu'ils veulent évaluer correctement les conditions météorologiques et élaborer la meilleure route vers le prochain port de destination.

Et qu'est-ce que l'IA nous apporte à nous, les navigateurs ?

Il est fort probable qu'à l'avenir, de plus en plus d'applications pourront créer un routing automatisé. Il suffira alors à l'utilisateur de saisir le départ et la destination, par exemple de Kiel à Rostock, et d'ajouter l'heure de départ souhaitée. Le système calcule alors le meilleur itinéraire en fonction des conditions météorologiques probables.

Quelles en sont les conséquences ? La navigation autonome, pilotée et surveillée par l'IA, est-elle inévitablement pour bientôt ? Nous sommes impatients de le savoir. Se fier entièrement à la technologie comporte toutefois des risques. Notamment parce que le système météorologique est si complexe et chaotique qu'il ne pourra jamais être entièrement modélisé. Des incertitudes subsistent. Surtout lorsqu'il s'agit de situations météorologiques difficiles, pour lesquelles plusieurs modèles doivent être consultés afin d'établir des prévisions fiables.

Une fois de plus, il convient de citer les situations météorologiques extrêmes. Il ne sera certainement pas possible de les classer avec précision pendant un certain temps encore sans le savoir et la longue expérience des spécialistes de la météo.

Et justement, avec les outils de routage auxquels beaucoup se fient déjà volontiers, la plupart ne savent pas qu'ils ne prennent souvent en compte que le vent moyen. Les rafales ou autres paramètres d'intempéries ne sont pas pris en compte. Si l'on télécharge ensuite les données météorologiques, qui n'ont par exemple qu'une résolution temporelle de trois heures, il se peut que l'on ne voie pas du tout une situation d'intempérie qui se prépare.

Il est donc indispensable de connaître les principes de base de la formation et de l'évolution des conditions météorologiques, et de savoir les utiliser correctement. Mais il faut aussi savoir comment se servir de tous ces nouveaux outils fascinants. Enfin, on ne peut pas nier l'évolution rapide de la technique. Avec l'intention d'améliorer les prévisions météorologiques, elle va changer le monde de manière positive, du moins dans ce domaine.

Pour ma part, je suis impatient de voir où le voyage va nous mener dans les années à venir - et je veux absolument en faire partie.

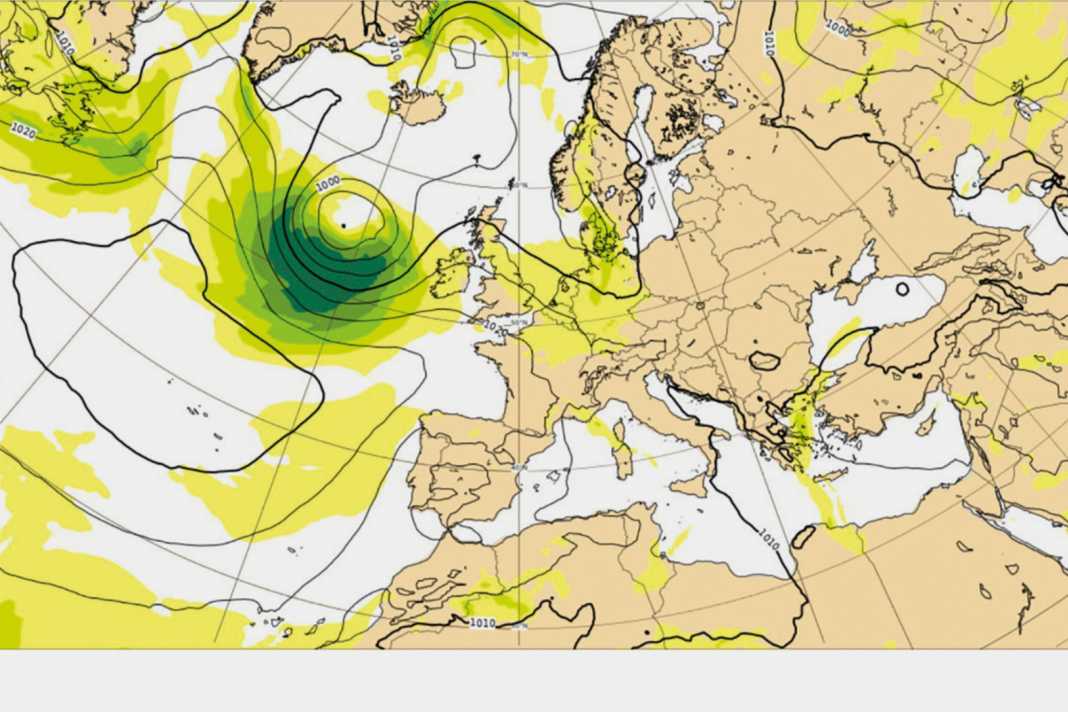

Comparaison des prédictions conventionnelles et des prédictions générées par l'IA

Sur charts.ecmwf.int permet de consulter sur Internet tous les produits de données du Centre météorologique européen ECMWF. On y trouve non seulement les prévisions du modèle opérationnel et numérique traditionnel, également utilisé par exemple dans Windy.com ou d'autres applications météo privées ou commerciales. Au contraire, on y trouve déjà - tout en bas de la page très chargée - les nouveaux modèles d'IA et les résultats qu'ils produisent : Alors qu'il n'y a guère d'écarts notables pour une prévision à relativement court terme, de l'ordre de 24 heures, les différences sont tout de même significatives pour une période de prévision plus longue.

Ci-dessus, à titre d'exemple, les cartes météo basées sur une prévision à dix jours de la répartition des pressions sur l'Europe du 31 juillet au 10 août 2024 : alors que le modèle numérique prévoit déjà une très puissante dépression au large de l'Irlande, les deux modèles d'IC prévoient également la formation de cette dépression, mais de manière encore nettement plus retardée et surtout beaucoup plus à l'ouest, avec le noyau seulement entre Terre-Neuve et le Groenland.

Quelle est la fiabilité des anciens et des nouveaux modèles de prévision météorologique ?

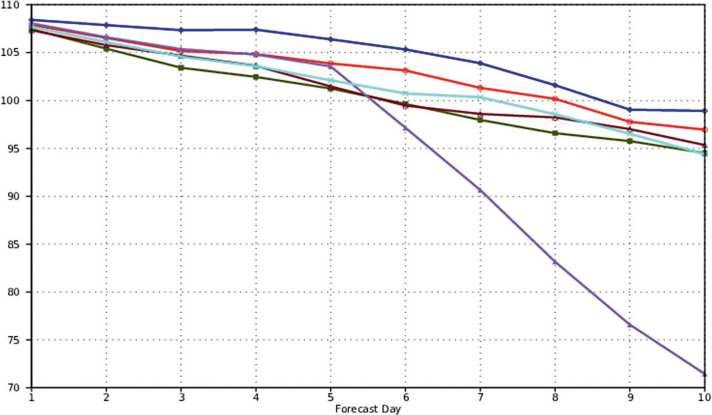

Les nouveaux modèles d'IA sont constamment comparés aux précédents. Leur comportement aussi. Et c'est ainsi que l'on observe par exemple l'activité des modèles entre eux. Si les graphiques évoluent de manière régulière, il faut s'attendre à peu de surprises dans les prévisions sur une période de dix jours. Seul le FuXI (un autre modèle d'IA) présente dans l'exemple un comportement très chaotique à partir du cinquième jour. En revanche, tous les autres modèles d'IA, qu'ils soient établis ou nouveaux, affichent une baisse détendue de la sécurité des prévisions. On considère d'ailleurs surtout les valeurs de 500 hPa, mesurées à environ 5,5 kilomètres d'altitude. Ce sont elles qui permettent le mieux de voir comment les hauts et les bas se comporteront également jusqu'au sol dans les prochains jours.

Il est tout simplement étonnant de constater que la plupart des modèles d'IA, comme c'est le cas ici dans l'exemple, ont un comportement similaire à celui des modèles AIFS et IFS établis du CEPMMT, et qu'ils présentent même déjà en partie une plus grande précision et sont moins sujets aux erreurs.